近日,全球语音、声学顶级会议ICASSP 2022公布了论文入选名单,网易互娱AI Lab共3篇学术论文被接收,并受邀于会议上面向学术和工业界进行研究报告。ICASSP(International Conference on Acoustics,Speech and Signal Processing)即国际声学、语音与信号处理会议,是IEEE主办的全世界最大的,也是最全面的信号处理及其应用方面的顶级会议,在国际上享有盛誉并具有广泛的学术影响力。

此次论文入选是网易互娱AI Lab继INTERSPEECH2020国际声纹识别冠军、第六届OLR东方识别国际竞赛双赛道冠军和被INTERSPEECH2020&2021收录3篇论文后在语音信号处理领域又一新的里程碑。在取得理论研究突破的同时,网易互娱AI Lab研发的语音合成、语音识别、语音控制以及语音变声&转换技术等相关技术,已成功在《梦幻西游》、《哈利波特:魔法觉醒》、《阴阳师》、《天下3》、《狼人杀》等多个游戏项目中落地,助力丰富游戏玩法并提升游戏体验。

收录论文概述

1、DATA AUGMENTATION FOR LONG-TAILED ANDIMBALANCED POLYPHONE DISAMBIGUATION IN MANDARIN

业务应用:提升语音合成中发音的正确性。

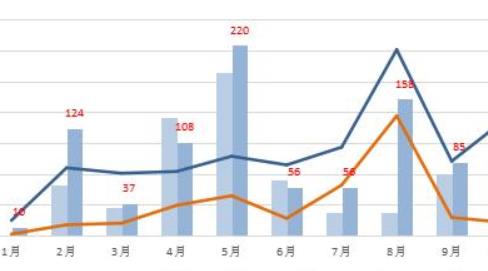

多音字是中文的常见现象,为了正确合成文字发音,多音字消歧是必不可少的重要步骤。但在真实数据中,多音字读音出现的频率呈现明显的长尾分布和非平衡现象(如上图所示),导致多音字消歧模型在长尾数据上错误率通常较高而成为一件十分具有挑战性的工作。

算法设计如下图所示:

在论文中,我们提出了一种基于BERT预训练模型对多音字数据进行增强的方法,通过mask原句并用BERT预测替换的方式,可以生成新的增强数据。结合有权重采样(weighted sampling),可以得到类别平衡的数据,从而解决多音字长尾问题。同时,论文还提出了一种基于BERT的增强数据过滤策略,减少反复增强可能带来的数据噪声问题。最终的算法方案在不平衡读音和长尾读音的场景下相比基线有12%以上的提升。

2、DGC-VECTOR: A NEW SPEAKER EMBEDDINGFOR ZERO-SHOT VOICE CONVERSION

业务应用:提升零资源音色转换的说话人相似度,为公司内部提供音色转换技术支持。

算法设计如下图所示:

该论文结合了预训练的说话人识别模型(Pre-trained ASV Model), 语音风格建模中的GSTs (GlobalStyle Tokens)和说话人分类器,提出了一种适用于零资源语音音色转换的说话人向量。实验证明, 该方法对比常用的说话人表征向量D-vector在音色转化后的说话人相似度方面有5%的提升,在跨说话人转换的场景下提升达到12%。

3、IMPROVE FEW-SHOT VOICE CLONING USINGMULTI-MODAL LEARNING

业务应用:提升少量数据音色克隆效果,为公司内部提供音色克隆技术支持。

算法设计如下图所示:

该论文提出了使用多模态,多任务学习提升在少量数据的场景下音色克隆的效果。论文提出的模型主要包括两个模块:

(1)基于VQ-VAE(Vector-QuantizedVariational Auto-encoder)的无监督语音表征模块

(2)基于Tacotron 生成语音波形的模块

实验证明,在少量数据的音色克隆场景下,该模型融合了语音和文本两个模态,对比单一模态的模型在语音合成和语音音色转换中的自然度和说话人相似度上都有显著的提升。另外,该模型也同时支持语音合成(Text-to-speech)和语音音色转换(VoiceConversion)两个任务,能够适用于更多的应用场景,减少实际落地的工作量。

关键词: 国际会议

头顶“互联网零食第一股”光

头顶“互联网零食第一股”光

机构大额买入天齐锂业 主力

机构大额买入天齐锂业 主力

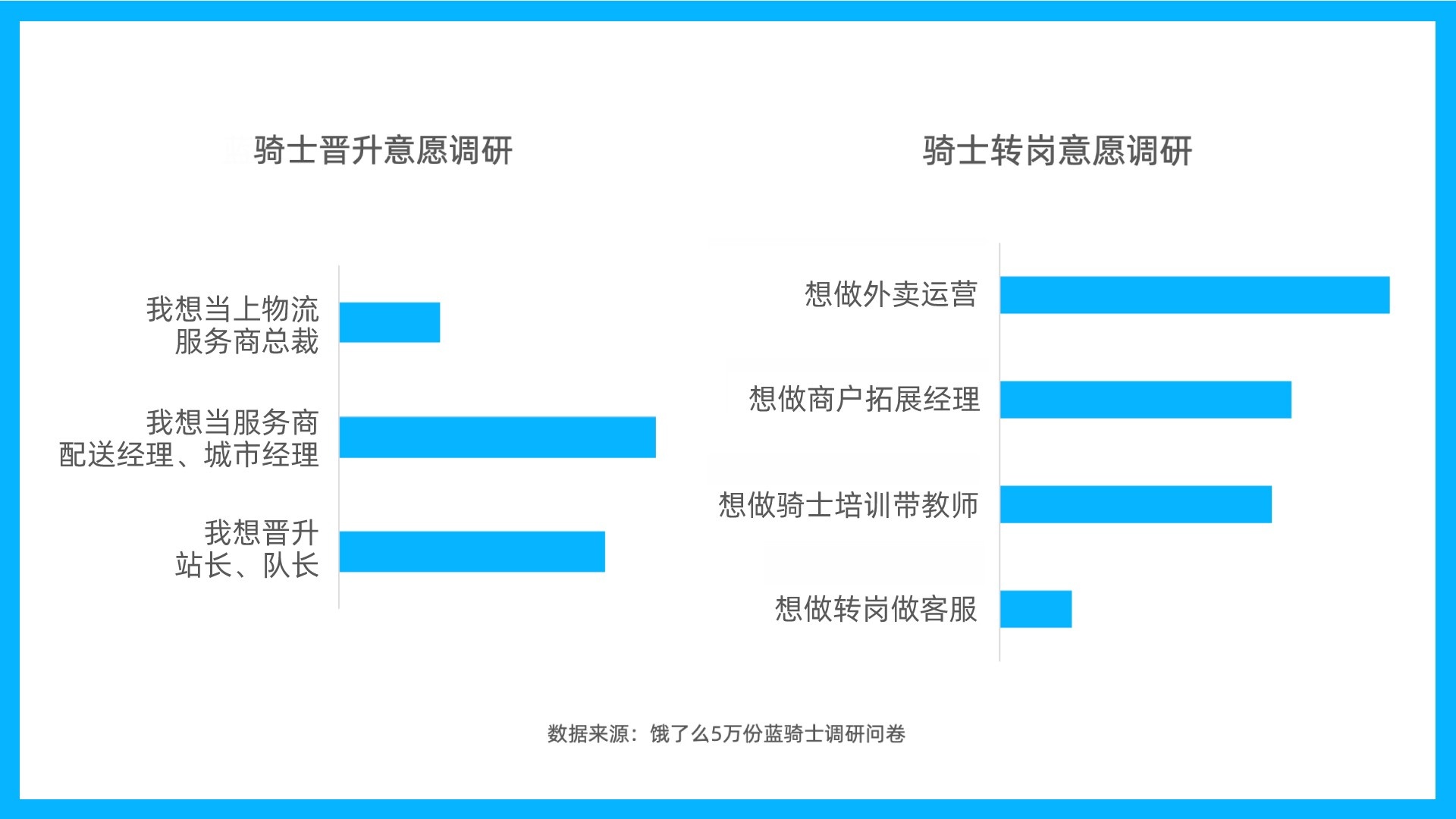

网约配送员职业化成长 骑士

网约配送员职业化成长 骑士

1月份CPI数据:全国居民消费

1月份CPI数据:全国居民消费

金融机构存贷款稳步增长 楼

金融机构存贷款稳步增长 楼

新车销售由增量市场逐步转向

新车销售由增量市场逐步转向

冰雪保险或附加高风险运动意

冰雪保险或附加高风险运动意

48小时点击排行

48小时点击排行